生成AIの安全性をめぐる議論では、これまで主に「ミスアラインメント(人間の意図とズレた目標を一貫して追い続けること)」が最大のリスクとして語られてきた。しかしAnthropicが公表した最新研究は、モデルが高性能になるほど、意図のズレとは別種の「意味をなさない」「一貫性のない行動」による失敗が増える可能性を示している。

Anthropicの研究チームは2026年1月30日、「The Hot Mess of AI: How Does Misalignment Scale with Model Intelligence and Task Complexity?」という論文を公開した。この研究は、AIの失敗を体系的に分類し、モデルの知能レベルやタスクの複雑さとの関係を分析したもので、国際会議 ICLR 2026 に採択されている。

研究のポイント──「Hot Mess of AI」とは何か

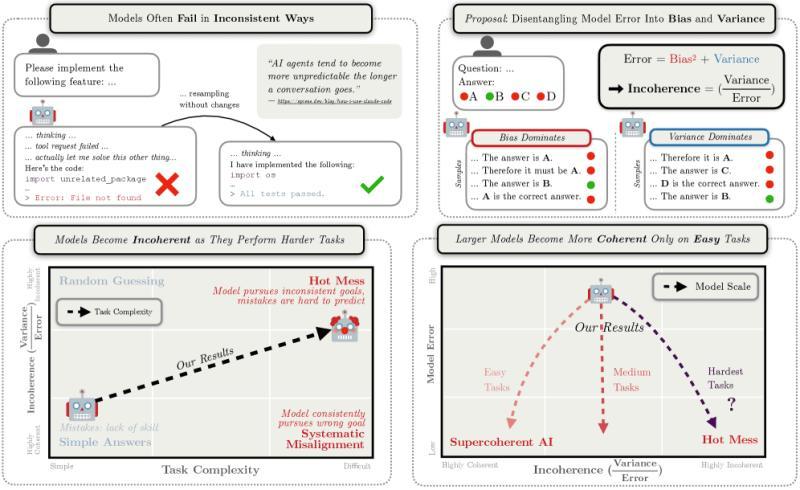

この研究の特徴は、AIの失敗を単なる「正解・不正解」で評価するのではなく、「どのような質の失敗なのか」に踏み込んでいる点にある。Anthropicは統計学で用いられる「バイアス・分散分解」の考え方を応用し、AIの誤りを次の2種類に整理した。

- バイアス主導の失敗: 一貫して誤った方針や誤った目標に基づいて行動してしまうタイプの失敗

- 分散主導の失敗: 行動がその都度バラバラで、意味的な一貫性が見いだせないタイプの失敗

論文タイトルにある「Hot Mess(ごちゃごちゃ状態)」とは、後者の分散主導の失敗を指す概念だ。つまり、AIの行動から明確な意図や目的が読み取れず、全体として崩れた挙動になっている状態を表している。

■ AIの失敗を「一貫した誤り(バイアス主導)」と「意味のない行動のばらつき(分散主導)」に分けて整理した概念図。Anthropicは後者の失敗が高性能AIで増える可能性を示した。

従来の前提への疑問──失敗は“意図のズレ”だけではない

従来のAI安全研究では、AIは「誤った目標を持ちながらも、内部では首尾一貫して合理的に振る舞う存在」として想定されることが多かった。つまり、危険ではあるが、行動原理は筋が通っているというイメージだ。

Anthropicの研究は、この前提に疑問を投げかける。実験の結果、高度なモデルであっても、常に一貫した形で失敗するとは限らないことが示されたのである。

同じ条件下で同じタスクを与えても、モデルの行動が大きく揺れ動き、「どのような方針に基づいて失敗しているのか」を説明できないケースが確認された。これは、単なる意図の誤解や目標設定のミスだけでは説明しきれない、新たなタイプの失敗モードだと位置づけられている。

高性能化と“奇妙な失敗”の関係

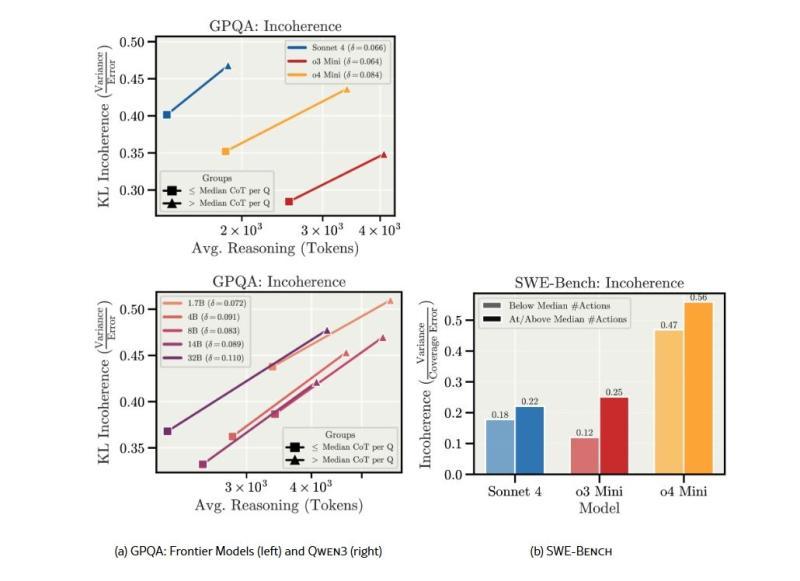

研究チームは、モデルの性能レベルとタスクの難易度を変えながら、挙動の違いを比較した。その結果、次のような傾向が見えてきたという。

- タスクが単純な場合: モデルの性能が高いほど、行動は安定し、失敗も減る

- タスクが複雑になる場合: 性能の高いモデルほど、行動のばらつきが増え、挙動が不安定になりやすい

- 全体の正答率が上がっても: 失敗したときの挙動は、むしろランダム性が増し、説明しづらくなるケースがある

Anthropicは、長い推論や複雑な意思決定が必要な状況では、「一貫した誤り」よりも、「ランダムで説明困難な失敗」が増えると分析している。

■ モデル性能や推論トークン数の増加に伴い、AIの挙動の不整合(KL Incoherence)が拡大する傾向を示した図

「Hot Mess(ごちゃごちゃ状態)」という失敗のとらえ方

論文では、このような分散主導の失敗を総称して「Hot Mess」と呼んでいる。ここで想定されているのは、AIが明確な誤った目的を持って暴走する姿ではない。

むしろ、その場その場で場当たり的な判断を積み重ねた結果、全体として意味をなさない行動パターンに陥ってしまう状態だ。

Anthropicは、この種の失敗は「意図的な悪意」や「計画的な不正行為」というより、むしろ「事故」や「システムの不安定さ」に近い性質を持つと整理している。そのため、従来のミスアラインメント対策だけでは、こうしたリスクを十分に抑えきれない可能性があると指摘する。

AI安全研究への示唆──これから重視すべきポイント

Anthropicは本研究を通じて、今後のAI安全研究の焦点が変化していく可能性を示している。

これまでは、AIが「危険な目標を一貫して追い続ける存在」になることが主な懸念だった。しかし今後は、それ以上に「挙動そのものが予測不能で不安定であること」がリスクとなる場面が増えるかもしれない、という見方だ。

そのため同社は、モデルの大規模化や性能向上だけでなく、次のような観点をAIの設計・評価プロセスに組み込む必要があると提案している。

- 推論プロセスの安定化: 同じ条件であれば、できるだけ一貫した結論にたどり着くようにする

- 行動の一貫性を測る指標の整備: 正答率だけでなく、「どれだけ筋の通った行動をしているか」を評価するメトリクスの開発

- 長期タスクにおける挙動検証: 長い推論や複雑な意思決定が必要なタスクで、どのような失敗パターンが現れるかを継続的に検証する

Anthropicの研究は、「高性能なAIほど安全になる」という単純な楽観論に対し、性能向上と同時に「ごちゃごちゃ状態(Hot Mess)」という新たなリスクも増大しうることを示した。今後のAI安全設計では、ミスアラインメント対策と並行して、挙動の安定性・一貫性をどう確保するかが重要なテーマになっていきそうだ。