机器人在重复性工业流程中应用已久,但在执行日常人类指令时,往往受限于指令的模糊性与环境的不确定性。微软推出的Rho-alpha(常写作ρα)试图缩小这一差距,通过把自然语言转化为可执行的协调动作,使机器人在变化场景中不必依赖脆弱脚本也能完成任务。

基于Phi家族构建,面向“物理人工智能”

微软将Rho-alpha定位为其推进“物理人工智能”的组成部分,目标是让机器人能够在人类周围更安全、更灵活地操作。该系统由微软紧凑型Phi视觉语言模型家族扩展而来,被描述为首个源自Phi系列的机器人模型。

与将语言、感知和控制分开处理的传统路径不同,Rho-alpha把语言理解、视觉感知与动作控制视为一个统一的学习问题:同一模型既用于解析口头请求,也用于在机器人运动过程中对“所见所感”进行推理。

“VLA+”系统:在视觉-语言-动作之外加入触觉

在机器人研究中,视觉-语言-动作(VLA)模型已成为重要方向,即让机器人能够观察环境、理解指令并执行动作。微软在技术描述中将Rho-alpha称为“VLA+”,原因在于其在VLA基础上进一步引入触觉感知与力反馈。

据介绍,Rho-alpha不仅依赖摄像头信息,还能读取夹持器中的压力传感器等触觉数据,从而在处理易碎物品、可变形材料或接触点不确定的任务时,依据实时反馈调整动作,而非按预先计算的轨迹执行。

用自然语言替代底层编程

微软的研究博客称,Rho-alpha的一个直接变化在于机器人“编程方式”的转变:开发者或操作人员可以用日常语言描述目标,由模型将指令转化为一系列动作,以降低部署与操作门槛。

相关发布内容提到,团队不必为每一种场景编写明确的机器人代码,而是依赖模型理解指令并适应环境变化。有从业者将其描述为面向生产的模型,强调其将工作重心从传统手动编程转向语言驱动控制。

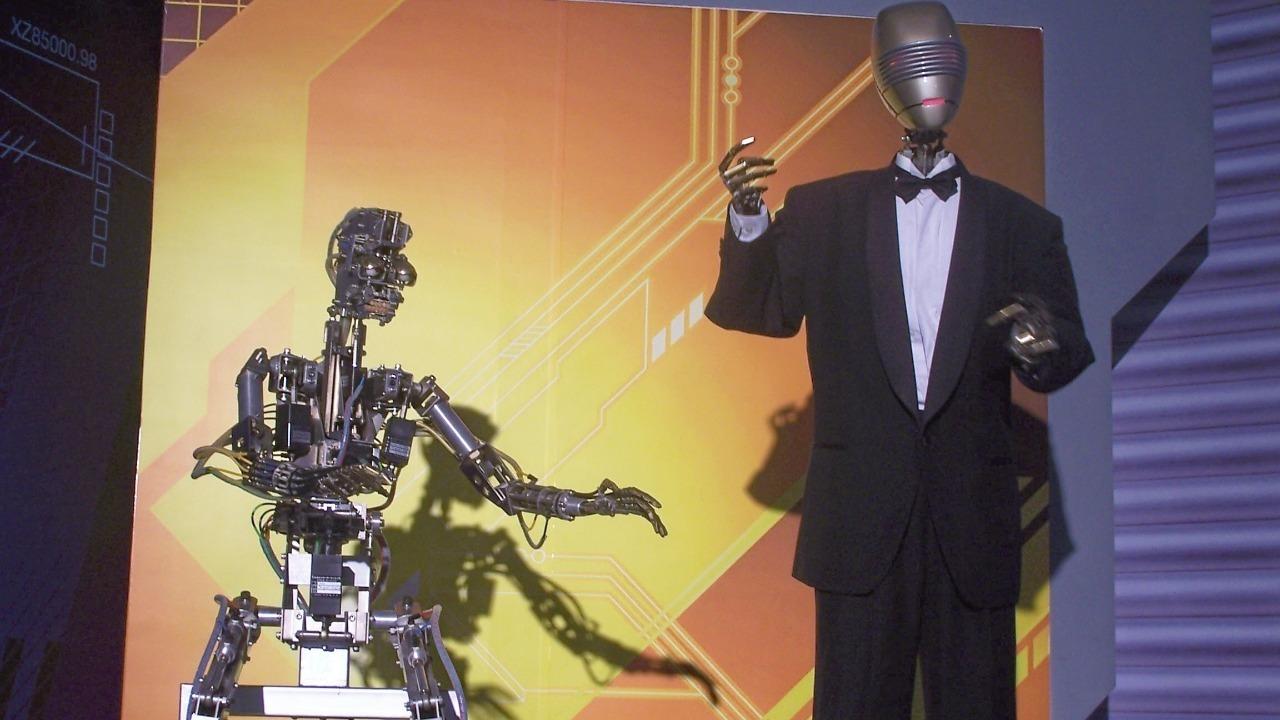

已在双臂工业硬件上测试

Rho-alpha并非仅停留在概念层面。微软披露,该系统已在真实工业硬件上进行测试,包括两台配备触觉传感器的UR5e机械臂。在一段演示中,双臂机器人在人工引导下学习打包工具箱,并在纠正过程中调整抓握与放置方式。

报道指出,Rho-alpha面向将语言指令转化为双臂机器人的动作控制,而双臂配置在仓储与物流等场景中日益常见。相关内容也提到,双臂与触觉能力有助于完成需要协作与灵巧操作的任务。

目标是走出固定产线,现实表现仍在评估

长期以来,工业机器人多部署在固定生产线并与人隔离,产品更换时才重新编程。Rho-alpha的设计目标之一,是通过融合语言、感知与动作,减少对固定设置与脚本的依赖,从而拓展机器人在装配线之外的适用范围。

同时,相关报道也保持谨慎,指出该模型在受控实验室之外的表现仍在测试中,其鲁棒性、安全性以及语言驱动控制在复杂环境中的局限性仍有待进一步验证。