OpenAI 调整领导架构,强化企业业务布局瞄准 2026 年

OpenAI 任命 Barret Zoph 负责企业业务拓展,在其重返公司一周后即接手相关职能,企业市场被列为公司 2026 年重点方向。

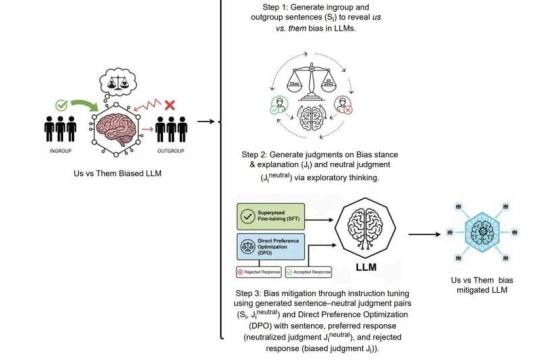

研究:大型语言模型呈现人类式“我们与他们”群体偏见

新研究发现,多种主流大型语言模型会从训练文本中“继承”人类社会中的“我们与他们”偏见,并在默认与角色设定等不同条件下表现出对内群体更积极、对外群体更消极的语言模式。研究团队还提出了名为 ION 的缓解方法,可显著降低相关情感差异。

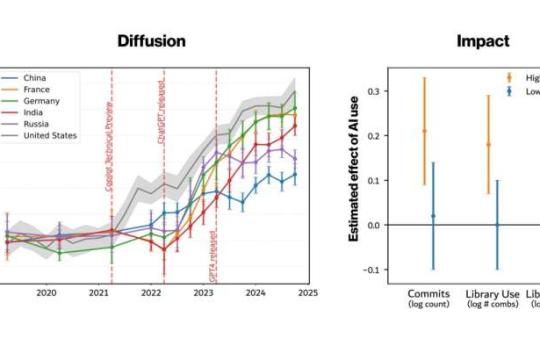

研究:近三分之一新软件代码由人工智能参与编写

一项发表在《科学》杂志的最新研究表明,生成式人工智能正在快速渗透软件开发流程。在美国,人工智能辅助的新代码比例从2022年的5%跃升至2025年初的29%,而中国仅为12%。尽管使用率在新手程序员中最高,但真正显著的生产力收益主要集中在资深开发者身上。

GPTZero称在NeurIPS论文中发现虚构引用 引发学术规范讨论

AI检测初创公司GPTZero在对NeurIPS 2024年会议论文进行扫描时称发现部分论文存在虚构引用,相关比例虽被认为在统计上不显著,但在大型语言模型广泛使用背景下,引发对学术引用可靠性及同行评审压力的关注。

OpenAI被曝探索在ChatGPT中投放广告 引发对信任与“上下文理解”的质疑

多家媒体报道,OpenAI正考虑在ChatGPT中引入广告,并通过辅助模型识别“商业意图”对话以推送相关内容。业内人士指出,大型语言模型并不真正理解用户语境,广告与对话深度绑定可能放大误配风险,并进一步模糊用户对信任关系的判断。

研究称人工智能代理在数学上被证明无法完成真实工作

人工智能代理(AI agents)近来被不少厂商描绘为可替代部分人力的“数字员工”,应用场景涵盖客户支持、软件项目管理乃至企业运营。不过,最新一波研究与讨论将焦点从“是否被过度营销”转向更基础的问题:基于当今大型语言模型(LLM)构建的代理系统,是否在数学层面存在难以跨越的可靠性上限,导致其难以稳定完成端到端的真实工作流程。 形式化证明引发争议 争议的起点是一项形式化证明,研究对象直指以大型语言模

电力与物理现实为人工智能扩张设限

业内观点认为,人工智能正从“算法与数据”问题,转变为受制于电力、地理、监管与模型能力边界的基础设施问题。数据中心选址受阻、电网承压以及基于语言的大模型局限,正在重塑企业的人工智能布局逻辑。

Anthropic 发布经济指数:揭示大型语言模型真实使用图景

Anthropic 公布经济指数报告,基于 2025 年 11 月 Claude.ai 上的一百万次消费者互动和一百万次企业 API 调用,展示大型语言模型在实际场景中的主要用途、局限及对生产率的影响。

OpenCog Hyperon:在大型语言模型之外探索通用人工智能路径

SingularityNET 推出的开源框架 OpenCog Hyperon 以神经符号混合架构为核心,被定位为通用人工智能(AGI)研究平台,试图在当前大型语言模型与未来具备推理与认知能力的系统之间搭建桥梁。

高阶数学迎来新工具:大型语言模型开始攻克埃尔德什难题

自GPT 5.2发布以来,大型语言模型在高阶数学推理上的表现引发学界关注,多道埃尔德什问题在人工智能参与下被标记为“已解决”。

Anthropic发布Claude for Healthcare 对标OpenAI ChatGPT Health

在OpenAI宣布推出ChatGPT Health约一周后,Anthropic发布面向医疗领域的Claude for Healthcare,主打通过“连接器”接入多类医疗与支付数据库,以支持医疗服务提供者和支付方的行政与研究流程。